Петербургские ученые создают технологию распознавания поддельных изображений

Кибермошенники используют новые методы обмана, применяя искусственный интеллект для создания точных цифровых копий людей. Они рассылают аудио и видео своих "двойников" знакомым жертв, прося их перечислить деньги.

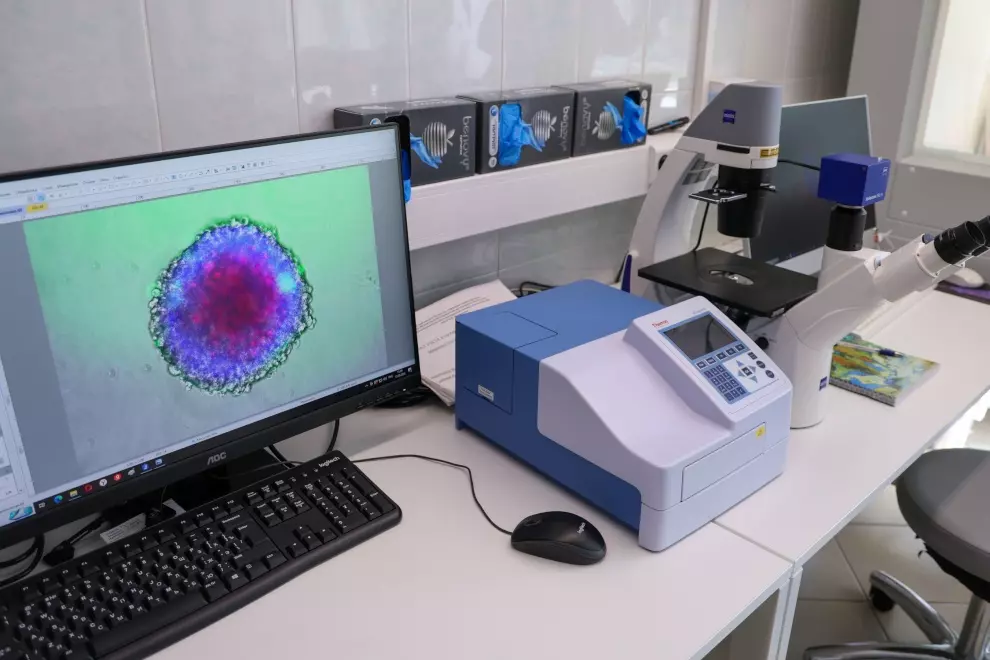

Чтобы противостоять этой угрозе, ученые из Санкт-Петербургского федерального исследовательского центра Российской академии наук разработали уникальную технологию распознавания дипфейков. Эта технология позволяет разоблачить поддельные изображения и видео, созданные с помощью нейросетей, всего за несколько секунд.

Как работает технология?

Анализ "шума": Любое отредактированное изображение содержит "шум", дополнительные наслоения, которые невооруженным глазом заметить сложно. Эта особенность помогает определить, была ли фотография или видеофайл изменен. Изменения цвета: Даже незначительные изменения в оттенках цвета, которые не видны на обычном мониторе, могут быть зафиксированы нейронными сетями. Движение: Отредактированные видеофайлы можно распознать по особенностям движения, так как нейросети не всегда могут точно имитировать естественные движения человека.

Ученые сконцентрировались на разоблачении фото-дипфейков, так как их подделка сложнее всего.

Дипфейки - не всегда зло. Используются в развлекательных целях, например, в создании фильмов и сериалов. Применяются на сайтах знакомств, чтобы скрыть недостатки внешности.

Но дипфейки могут быть очень опасными в руках мошенников. Могут использоваться для выманивания денег у жертв, заменяя лица и голоса настоящих людей. Создаются политические провокационные видео, чтобы дискредитировать людей. В судах подозреваемые могут подделывать улики и создавать ложные алиби.

Разработка петербургских ученых будет иметь большое значение в будущем:

Исследователи работают над созданием открытой базы данных, которая будет доступна всем желающим:

По условиям гранта, полученного от Фонда содействия инновациям, уже через полтора года будет создана библиотека интеллектуальных методов распознавания поддельных или измененных изображений человеческих лиц.

0

0

0

0

0

Актуальное

Новые тарифы на жилищно-коммунальные услуги будут действовать с 1 июля

С 1 июля 2025 года в Санкт-Петербурге, как и по всей стране, вступят в силу новые тарифы на жилищно-коммунальные услуги. Это изменение обусловлено федеральным законодательством и является первым комплексным пересмотром тарифов в городе с декабря 2022 года. На протяжении более двух с половиной лет тарифы на водоснабжение, водоотведение, теплоснабжение и обращение с твердыми коммунальными отходами (ТКО) оставались неизменными. В течение этого периода корректировки цен проводились только в отношени

Петербургские семьи смогут получить до 1 млн рублей на погашение ипотеки

С сегодняшнего дня многодетные семьи Санкт-Петербурга, в которых третий или последующие дети появились на свет в период с 1 января 2025 года по 31 декабря 2027 года, имеют возможность получить до 1 миллиона рублей для погашения ипотечного кредита. Для этого необходимо подать заявку на федеральную выплату, которая может составлять до 450 тысяч рублей, а также на дополнительную помощь от региона в размере до 550 тысяч рублей. Заявки принимаются через портал Госуслуг. При этом важно, чтобы кредитны

Александр Беглов подписал Закон «О внесении изменения в Закон Санкт‑Петербурга «Социальный кодекс Санкт‑Петербурга»

Губернатор Санкт-Петербурга Александр Беглов подписал новый Закон, касающийся изменений в «Социальном кодексе Санкт-Петербурга». Этот документ вводит значительное увеличение размера социальной помощи, которая будет предоставляться в виде ежемесячных денежных выплат на содержание детей-сирот, а также детей, оставшихся без попечения родителей, которые находятся под опекой или попечительством.

Владельцы карты «Серебряный возраст» подали заявки на получение сертификата для посещения музеев

Более ста тысяч жителей Санкт-Петербурга, являющихся владельцами карты «Серебряный возраст», уже подали заявки на получение электронного сертификата, предоставляющего право на приобретение билетов в городские музеи на сумму 1500 рублей. Эта инициатива, запущенная в рамках городской программы «Серебряный возраст» по распоряжению губернатора Александра Беглова, действует в Санкт-Петербурге с первого марта 2025 года. Карта «Серебряный возраст» доступна женщинам с 55 лет и мужчинам с 60 лет. Сертифи

Первый этап линии «Купчино-Шушары-Славянка» запустят сегодня

Сегодня состоится запуск первого этапа трамвайной линии «Купчино-Шушары-Славянка». В Санкт-Петербурге начнется регулярное движение трамваев по маршруту номер 2. Транспорт будет курсировать по участку, который пролегает от станции метро «Купчино» до Валдайской улицы в Шушарах. Время ожидания трамвая на конечных остановках составит примерно 5 минут, а общая продолжительность маршрута составит 17 минут.

Прошла церемония передачи военнослужащим Росгвардии ключей от квартир в новом жилом доме

В торжественной церемонии вручения ключей от новых квартир военнослужащим Росгвардии приняли участие губернатор Санкт-Петербурга Александр Беглов и командующий войсками национальной гвардии РФ по Северо-Западному федеральному округу Сергей Бураков. Первыми обладателями жилья стали двадцать сотрудников Росгвардии, участвовавших в специальной военной операции, и члены их семей.

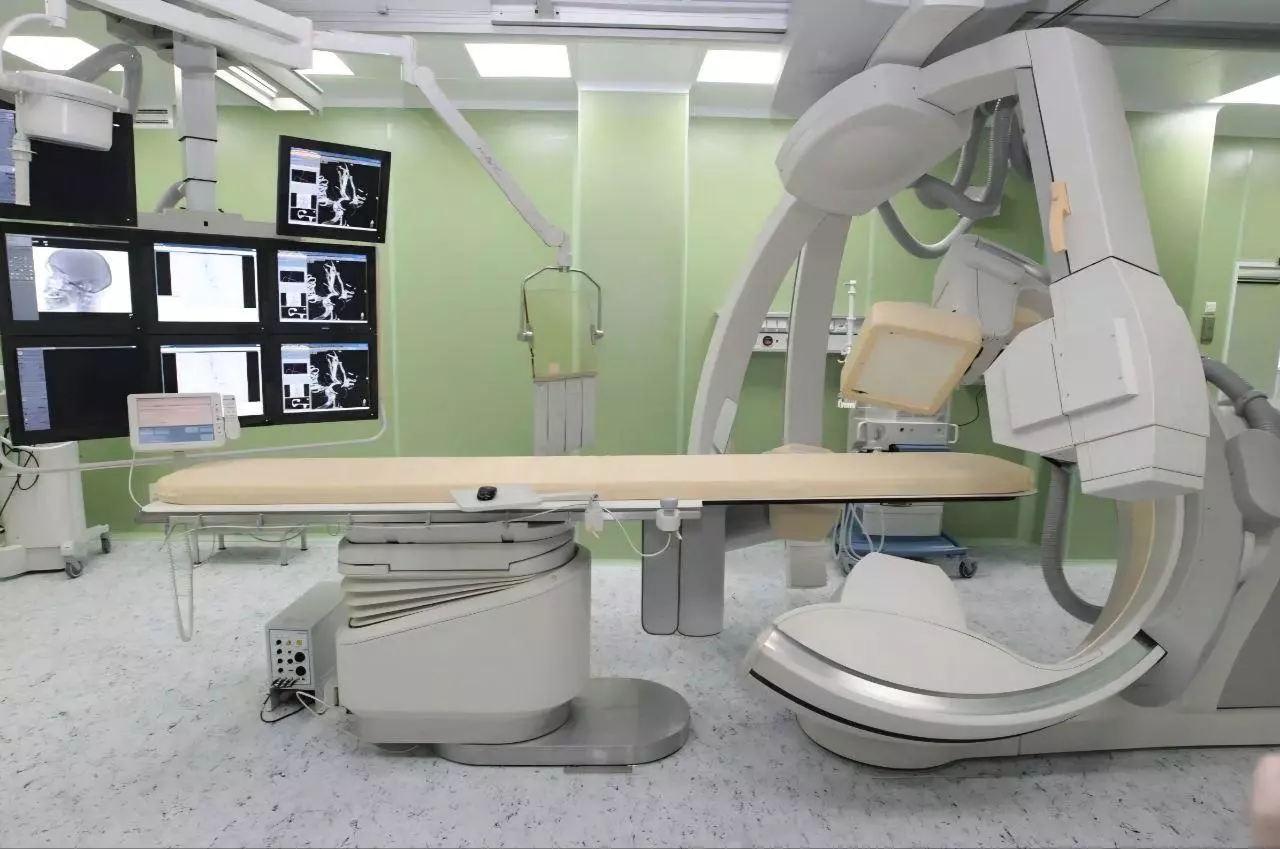

В Мариинской больнице успешно выполнена трансплантация сердца

В Мариинской больнице Санкт-Петербурга успешно завершена вторая по счету операция по трансплантации сердца. Это значимое событие, поскольку ранее подобные высокосложные вмешательства в городе проводились исключительно в федеральных медицинских учреждениях. Первая трансплантация сердца в этом стационаре состоялась в конце апреля текущего года. Успешная операция стала результатом реализации программы «Лечение пациентов с терминальными формами хронической сердечной недостаточности», инициированной

В Петербурге стартует четвертый Гастрономический фестиваль

Четвертый по счету Гастрономический фестиваль распахнет свои двери 24 июля на Пионерской площади Санкт-Петербурга, расположившись перед зданием Театра юного зрителя. В течение четырех дней, с 24 по 27 июля, более двадцати регионов России представят на фестивале увлекательное путешествие в мир русской кухни, демонстрируя её эволюцию, вкусовые особенности и современные кулинарные технологии.

Забота о людях «серебряного возраста» – один из приоритетов развития города

С начала 2025 года 5324 петербуржца, относящихся к категории «серебряный возраст», обратились за помощью в трудоустройстве в районные Кадровые центры. Это число на 32,6% превышает аналогичный показатель за тот же период 2024 года. Почти половина из этих соискателей, находящихся на пенсии или приближающихся к ней, уже смогла найти подходящую работу. Город активно поддерживает инициативы своих граждан в рамках проекта «Серебряный возраст». Губернатор Александр Беглов отметил, что забота о людях эт

Долгожданное открытие и настоящий прорыв для городского транспорта

Долгожданное событие и значительный шаг вперед для городского общественного транспорта – это открытие первого в России скоростного трамвая. Губернатор Санкт-Петербурга Александр Беглов лично дал старт движению на одном из участков. С сегодняшнего дня, начиная с трех часов дня, пассажиры смогут воспользоваться вторым маршрутом. Первый трамвай, сверкающий новогодними огнями, отправляется из Шушар и прибывает на станцию «Купчино». Открытие линии, строительство которой заняло чуть больше года, курир

В городе стартует XIV Санкт‑Петербургский международный фестиваль «Опера – всем»

Двенадцатого июля в Санкт-Петербурге стартует четырнадцатый по счёту международный фестиваль «Опера – всем». Это масштабное мероприятие, проводимое под открытым небом, предоставляет любителям прекрасного уникальную возможность насладиться подлинными шедеврами музыкального искусства. Глава города, губернатор Александр Беглов, обращаясь к участникам, организаторам и гостям фестиваля, особо отметил его значимость как одного из самых популярных и ожидаемых общедоступных культурных событий летнего се

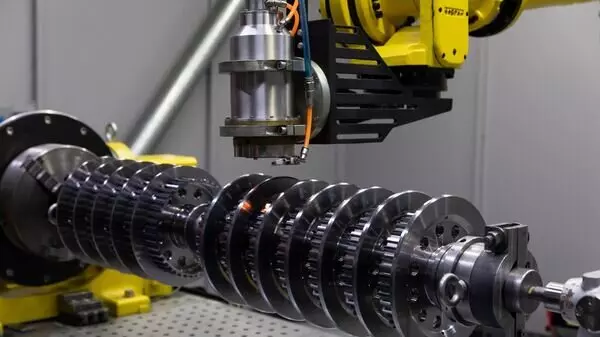

В городе идёт активное строительство новой линии метрополитена

В Санкт-Петербурге идёт активное строительство новой линии метрополитена. Строители метрополитена завершили монтаж половины нового тоннелепроходческого комплекса диаметром 5,6 метра, изготовленного на «Обуховском заводе». Установка осуществляется в стартовой шахте, расположенной на новом участке Красносельско-Калининской линии на глубине более 60 метров.

Президент России подписал закон о создании цифрового сервиса

Глава Российской Федерации, Владимир Владимирович Путин, утвердил законодательный акт, устанавливающий создание инновационной, многофункциональной цифровой платформы для обмена информацией. Этот документ был обнародован на официальном интернет-портале, предоставляющем доступ к правовой информации.

На новой шестой линии Петербургского метрополитена стартовала обкатка пускового участка

На новой шестой линии Петербургского метрополитена стартовала обкатка пускового участка. Первый тестовый поезд преодолел 5-километровый участок, который соединяет станцию «Нарвская» первой линии с платформой станции «Юго-Западная» шестой Красносельско-Калининской линии. В качестве первопроходцев выступили ветераны — знаменитые вагоны серии «Ем». После открытия шестой линии регулярные рейсы с пассажирами будут выполнять современные вагоны «Балтиец», которые имеют особое коричневое оформление, гар

Новые центры «Серебряный возраст» появятся в городе

Сегодня, 6 ноября, губернатор города провел личный прием граждан на площадке Регионального отделения Партии «Единая Россия», где он поделился важной информацией. В мероприятии участвовал Секретарь Санкт-Петербургского регионального отделения этой партии, Александр Бельский. Во время приема одна из пенсионерок, которая активно участвует в волонтерском движении и была участницей XVIII Международного форума «Старшее поколение», задала вопрос о будущем создании Центров для пожилых людей. Она также в

В «Экспофоруме» начала работу 18-я Международная выставка «НЕВА 2025»

В Санкт-Петербурге, на площадке выставочного центра «Экспофорум», сегодня стартовала 18-я по счету Международная выставка и конференция, посвященная гражданскому судостроению, судоходству, портовой деятельности, а также освоению океана и шельфа. Мероприятие носит название «НЕВА 2025». На объединенном стенде, представляющем Санкт-Петербург, ведущие предприятия города демонстрируют достижения отечественной морской робототехники. Экспозиция включает в себя образцы безэкипажных катеров с системами у

В ближайшие выходные стартует Большой семейный фестиваль

В ближайшие выходные Санкт-Петербург вновь станет местом проведения масштабного семейного фестиваля. Мероприятия фестиваля, запланированные на 12 и 13 июля в Южно-Приморском парке, адресованы жителям Красносельского (12 июля) и Петродворцового (13 июля) районов. В текущем году планируется проведение десяти подобных фестивалей, включая один общегородской, который состоится в парке 300-летия Санкт-Петербурга в первые выходные сентября.

В городе проходит международная конференция по борьбе с инфекционными заболеваниями

Сегодня, 11 декабря, губернатор Александр Белов и Анна Попова, являющаяся руководителем Роспотребнадзора и главным государственным санитарным врачом Российской Федерации, открыли VI Международную научно-практическую конференцию, посвящённую вопросам борьбы с инфекционными заболеваниями. На протяжении двух дней в Президентской библиотеке имени Б.Н. Ельцина учёные из трёх континентов будут представлять результаты своих исследований и участвовать в обсуждениях. Одним из важных мероприятий конференц

Почетными наградами и Благодарностей Президента удостоены петербуржцы

Губернатор Александр Беглов, действуя по поручению Президента России, сегодня в Смольном вручил государственные награды и поощрения от главы государства. Награды, такие как ордена, медали, почётные звания, почётные грамоты и Благодарности Президента, были вручены петербуржцам, которые достигли значительных успехов в своей профессиональной деятельности. Среди награждённых оказались врачи, учителя, артисты, инженеры, исследователи, реставраторы, архивисты, руководители предприятий и госслужащие.

В городе начнется периодическое протапливание

В городе Санкт-Петербурге с 9:00 25 сентября запланировано начало периодического включения отопления в связи с ожидаемым снижением температуры воздуха. Это решение утверждено соответствующим распоряжением Комитета по энергетике и инженерному обеспечению, подписанным сегодня. Периодическое протапливание представляет собой поэтапный запуск системы теплоснабжения с постепенным увеличением мощности теплоисточников, работающих на пониженных параметрах. Такой плавный подход обеспечит управляющим компа

День Зеленогорска

Дорогие жители Зеленогорска! Сегодня мы торжественно отмечаем День города – знаменательную дату нашего любимого курортного поселения, расположенного на живописном берегу Финского залива! За 477 лет своего существования Зеленогорск прошел впечатляющий путь развития, преобразовавшись из небольшой рыбацкой деревни в настоящую жемчужину Карельского перешейка. В этот день мы также вспоминаем о героическом прошлом нашего города. Постановлением Президента Российской Федерации установлена памятная дата

Николо-Богоявленский Морской собор получил новую архитектурно-художественную подсветку

Накануне праздника Рождества Христова один из ключевых духовных и архитектурных символов Санкт-Петербурга — Николо-Богоявленский Морской собор — был оснащен новой архитектурно-художественной подсветкой. Предыдущая система освещения была установлена почти три десятилетия назад. В процессе модернизации было установлено 100 современных светодиодных осветительных приборов и проложено 732 метра новой кабельной линии. Вокруг недавно отреставрированной колокольни на специальных опорах были установлены

В предстоящие выходные шоу «Поющие мосты» будет посвящено Дню семьи, любви и верности

В предстоящие выходные в Санкт-Петербурге пройдет звуковое шоу «Поющие мосты», посвященное Дню семьи, любви и верности. Это событие будет отмечено трогательным музыкальным плейлистом, который был специально подготовлен к этому празднику, который каждый год отмечается 8 июля. Главный редактор газеты «Петербургский дневник» Кирилл Смирнов подчеркнул, что программа выбрана таким образом, чтобы затрагивать важнейшие темы — любовь, заботу родителей и семейные традиции.

В ближайшие выходные в Сестрорецке состоится очередной Большой семейный фестиваль

В Сестрорецке 9 и 10 августа состоится масштабный семейный фестиваль, предназначенный для жителей Курортного и Кронштадтского районов Санкт-Петербурга. Мероприятие, запланированное на выходные дни, предложит гостям обширную программу, включающую в себя двадцать восемь тематических и интерактивных площадок.

Александр Беглов вручил награды лучшим сотрудникам вуза СЗГМУ им. И.И.Мечникова

Сегодня состоялось заседание учёного совета Северо-Западного государственного медицинского университета имени И.И. Мечникова, в котором принял участие губернатор Санкт-Петербурга Александр Беглов. Главной темой заседания стало чествование 140-летнего юбилея Клинического института Великой княгини Елены Павловны. Этот институт является одним из предшественников современного Северо-Западного государственного медицинского университета имени И.И. Мечникова, его историческое значение для развития меди

В Смольном состоялась церемония награждения выдающихся петербуржцев

В Смольном состоялась церемония награждения выдающихся петербуржцев. Губернатор Санкт-Петербурга Александр Беглов, выполняя поручение Президента Российской Федерации Владимира Путина, вручил государственные награды и поощрения. Среди награжденных были представители различных профессий и возрастных категорий: врачи, деятели культуры и искусства, а также представители бизнеса и промышленности.

Новые объекты относящие к сфере здравоохранения запустят в городе

В текущем году в Санкт-Петербурге планируется запустить в работу двадцать один объект, относящийся к сфере здравоохранения. Об этом сообщил губернатор города Александр Беглов в своём ежегодном обращении к жителям. В качестве примера уже функционирующих объектов он привёл новый корпус 40-й больницы в Сестрорецке, а также детские поликлиники, открытые в Калининском районе и в Шушарах. До завершения года намечено ввести в эксплуатацию три новых корпуса городских больниц, две подстанции скорой медиц

Губернатор подписал постановление «О присуждении премии Правительства Санкт‑Петербурга в области образования в 2025 году»

Губернатор Санкт-Петербурга Александр Беглов утвердил постановление Правительства города о вручении премии Правительства Санкт-Петербурга в сфере образования за 2025 год. Это решение стало итогом ежегодного конкурса, организованного Комитетом по образованию Санкт-Петербурга. В рамках данного конкурса были определены победители, которые получат денежные вознаграждения.

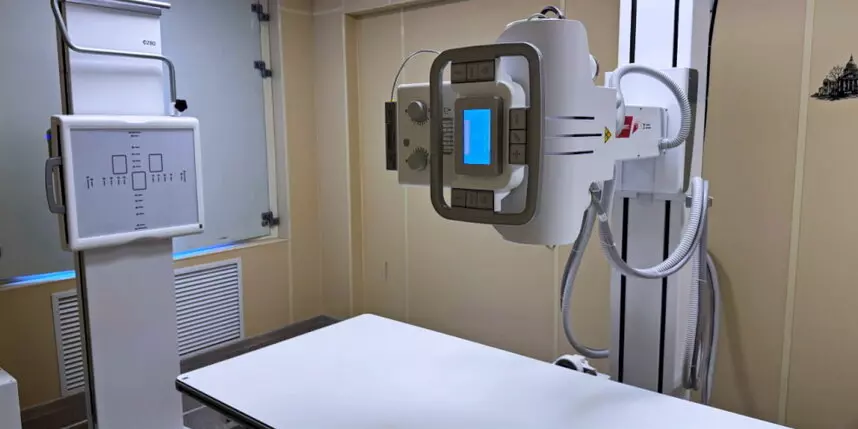

Считанные недели остаются до открытия современной поликлиники

В Красногвардейском районе совсем скоро откроется новая современная поликлиника, рассчитанная на 26 тысяч пациентов. В учреждении будут использоваться отечественное рентгеновское оборудование, маммограф и станция скорой помощи. Интересно, что анализ снимков будет проводиться с помощью искусственного интеллекта. Это открытие является частью широкой программы по улучшению здравоохранения в этом районе.

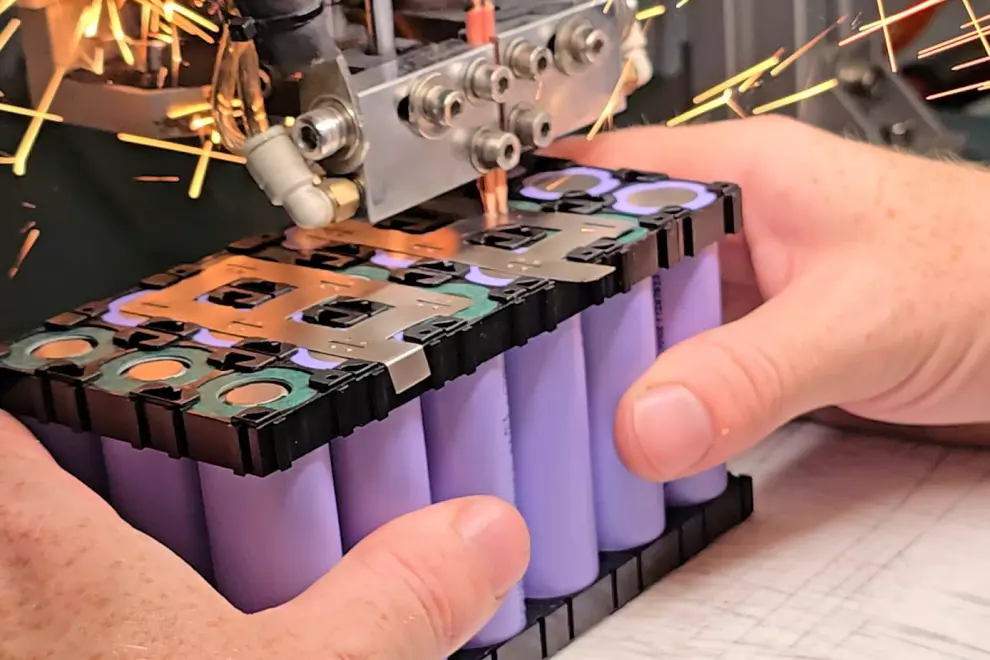

Метростроители завершили монтаж панно на новой Красносельско-Калининской линии «Путиловская»

Строители метро в Санкт-Петербурге завершили установку крупного панно в вестибюле новой станции Красносельско-Калининской линии под названием «Путиловская». Это панно изготовлено из сотовых алюминиевых панелей, на которые нанесен печатный рисунок. Художественная концепция панно основана на истории Путиловского завода и абстрактно иллюстрирует процессы в машиностроении, чугунолитейном и художественно-литейном производстве. Ширина этого панно, расположенного над эскалаторами, колеблется от 8 до 15

В Пушкинском районе продолжается строительство крупного инфраструктурного объекта

В Пушкинском районе продолжается реализация масштабного инфраструктурного проекта – Южной широтной магистрали. На сегодняшний момент уровень готовности строительства составляет 60%. Уже начато рабочее движение по путепроводу, который расположен в створе Петербургского шоссе – это один из трёх путепроводов, входящих в состав новой магистрали. В ноябре специалисты завершили бетонирование пролета на путепроводе, который проходит над железнодорожными путями Витебского направления, и его готовность н

В «Пулково» состоялась торжественная церемония посвященная открытию авиасообщения между Петербургом, Варадеро и Каракасом

В аэропорту «Пулково» прошла торжественная церемония, посвященная открытию прямого авиасообщения между Санкт-Петербургом и такими городами, как Варадеро и Каракас. Самолет авиакомпании «Conviasa», который вылетел накануне из международного аэропорта имени Симона Боливара, успешно приземлился на берегах Невы и, согласно традиции, был встречен водяной аркой. Церемония, приуроченная к первому прямому рейсу из Каракаса через кубинский Варадеро в Петербург, состоялась в столице Боливарианской республ

В городе началась неделя профилактики инфекций, передаваемых половым путём

В Санкт-Петербурге началась неделя, посвященная предотвращению распространения заболеваний, передающихся половым путем. Согласно данным специалистов, за последние три года наблюдается стабильное уменьшение количества таких инфекций на 12,3 процента. Однако крайне важно помнить, что своевременная диагностика и адекватное медицинское вмешательство значительно снижают вероятность развития осложнений и увеличивают возможности полного выздоровления. Главный врач Санкт-Петербургского государственного

В парке Авиаторов состоится праздник – «Большой семейный фестиваль»

В Парке Авиаторов 19 и 20 июля состоится масштабное мероприятие – «Большой семейный фестиваль», предназначенное для жителей Московского и Кировского районов Санкт-Петербурга. Организаторы подготовили обширную программу, включающую в себя 28 тематических площадок. На этих площадках посетителей ждут разнообразные мастер-классы, интерактивные конкурсы и игры, а также познавательные лекции и увлекательные представления.

В городе стартовал фестиваль ледовых скульптур

На Заячьем острове начался фестиваль ледяных скульптур. Здесь можно увидеть как крупные, так и мелкие, яркие и прозрачные арт-объекты, созданные мастерами из различных уголков нашей страны. В этом году главным персонажем фестиваля стал сам Санкт-Петербург — город, в котором переплетаются множество традиций и культур. Среди экспонатов можно увидеть волшебного оленя по имени Серебряное копытце, который выбивает драгоценные камни у Ростральных колонн. Также представлен Улан-батыр, главный герой баш

Петербург встречает мощи святителя Луки Крымского

Сегодня в Храм Казанской иконы Божией Матери, расположенный в Воскресенском Новодевичьем монастыре Санкт-Петербурга, прибыл ковчег, содержащий мощи святителя Луки Крымского. Святыня доставлена из симферопольского Свято-Троицкого женского монастыря. Губернатор Санкт-Петербурга Александр Беглов заявил о знаменательном событии, подчеркнув, что Петербург с почтением встречает мощи святителя Луки Крымского – выдающегося епископа и подвижника Православной веры. Он отметил, что вся жизнь святителя была

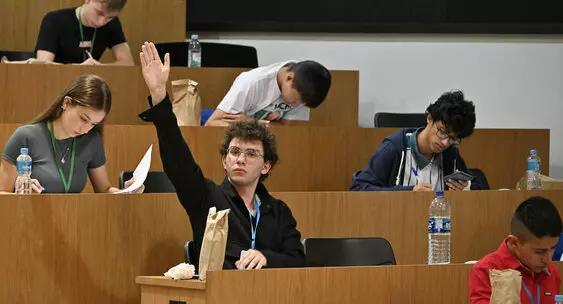

В городе стартует профориентационный проект «Школа Смольного»

Сегодня, 20 ноября, начинается профориентационный проект под названием «Школа Смольного». На протяжении пяти месяцев старшеклассники из Санкт-Петербурга, которые успешно прошли конкурсный отбор, будут каждую неделю участвовать в лекциях и занятиях, а также посещать ключевые высшие учебные заведения и государственные учреждения города. Участников познакомят с деятельностью органов государственной власти через интерактивные форматы, такие как экскурсии, деловые игры, квизы и конкурсы. Это позволит

После завершения реставрации памятник архитектуры федерального значения передан Генеральной прокуратуре РФ

Сегодня, 26 декабря, губернатор Санкт-Петербурга Александр Беглов передал Генеральному прокурору Российской Федерации Александру Гуцану здание Дома Кочубея. После завершения его реставрации, это памятник архитектуры федерального значения был передан в ведение Генеральной прокуратуры РФ. В торжественной церемонии открытия и передачи здания также приняли участие Полномочный представитель Президента России в Северо-Западном федеральном округе Игорь Руденя и председатель Законодательного Собрания Са

Свое 125-летие профессионального проектирования боевых подводных лодок отметил ЦКБ «Рубин»

Сегодня, 22 декабря, в Санкт-Петербурге прошло торжественное мероприятие, посвященное 125-летию профессионального проектирования боевых подводных лодок и созданию Центрального конструкторского бюро морской техники «Рубин». В честь юбилея ЦКБ «Рубин» были вручены высокие награды от города и государства. Орден Александра Невского на знамя предприятия прикрепил Николай Патрушев, который является помощником Президента Российской Федерации и председателем Морской коллегии РФ. Губернатор Санкт-Петербу

Владимир Путин произвел проверку проведения оперативного учения «Июльский шторм»

В День Военно-Морского Флота России, 27 июля, Президент Российской Федерации Владимир Путин посетил Санкт-Петербург, морскую столицу страны. В ходе визита, Верховный Главнокомандующий Вооружёнными Силами РФ посредством видеоконференцсвязи осуществил наблюдение за ходом оперативного учения «Июльский шторм». Учения проводились в операционных зонах Северного, Тихоокеанского, Балтийского, Черноморского флотов и Каспийской флотилии. Президент отметил, что учения проходят в условиях, максимально прибл

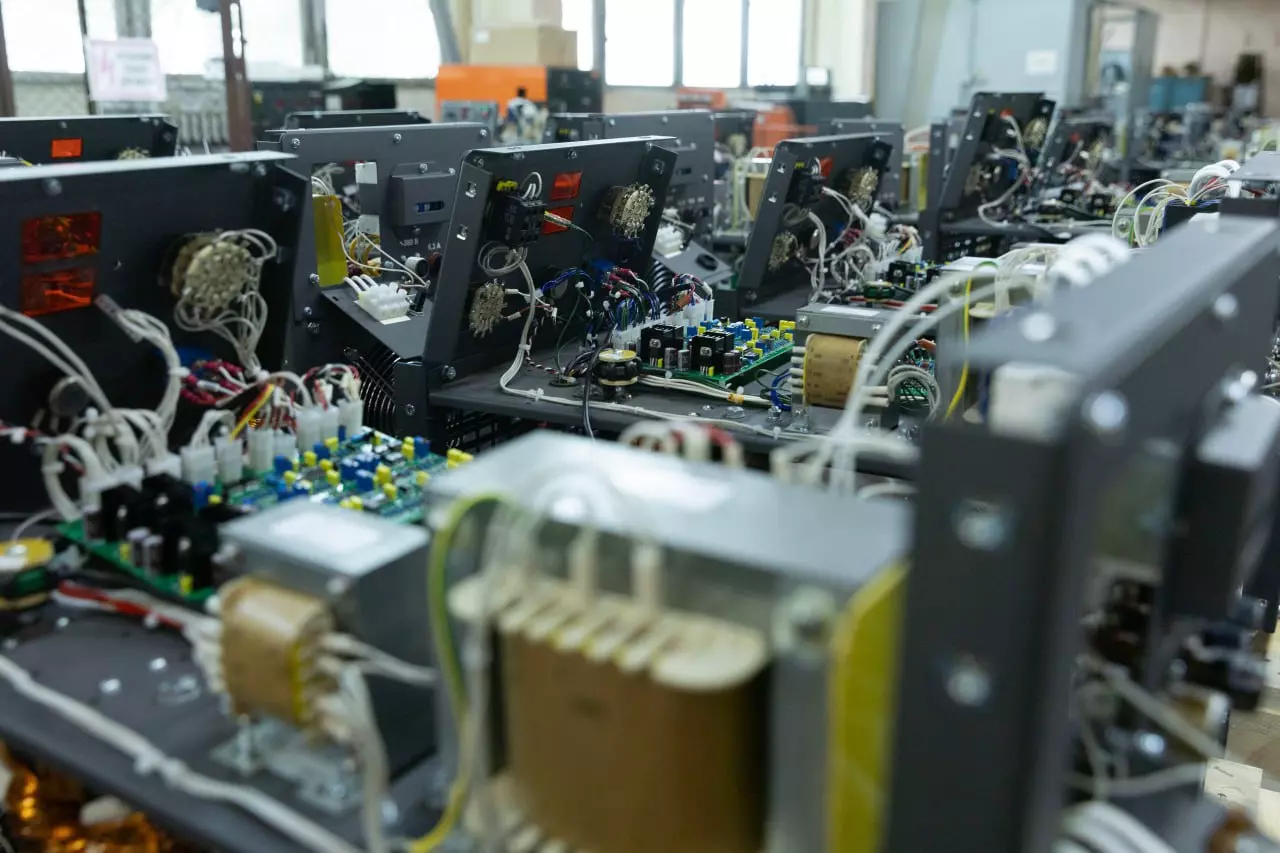

На строящейся трамвайной линии «Славянка» собраны и установлены шесть тяговых подстанций

На строящейся трамвайной линии «Славянка» уже смонтированы и установлены шесть из одиннадцати необходимых тяговых подстанций. Эти подстанции являются критически важным элементом инфраструктуры электротранспорта, обеспечивающим бесперебойное электроснабжение трамваев на значительных участках пути. Шесть установленных подстанций обеспечивают функционирование первого этапа линии, соединяющего станцию метро «Купчино» и трамвайное депо в поселке Шушары.

50 лучших педагогов дополнительного образования получат по 200 тысяч рублей

Губернатор Северной столицы, Александр Беглов, официально утвердил нормативно-правовой документ – постановление, которое регулирует порядок присуждения премии Правительства Санкт-Петербурга, носящей официальное наименование «Лучший педагог дополнительного образования государственного образовательного учреждения Санкт-Петербурга», запланированной к вручению в две тысячи двадцать пятом году.

«Парк Победы» закрыли на реконструкцию

Метростанция "Парк Победы" временно закрыта для проведения масштабной реконструкции. В рамках ремонтных работ запланировано полное обновление гидроизоляционной системы наклонного пассажирского хода. Кроме того, будет осуществлена полная замена всех эскалаторов, а также построение нового вестибюля станции. Для обеспечения бесперебойного сообщения пассажиров в период закрытия станции "Парк Победы" будет значительно увеличено количество маршрутов общественного транспорта, следующих до ближайших ста

Ковчег прибыл в Казанский собор Петербурга

Губернатор Санкт-Петербурга Александр Беглов принял участие в торжественном мероприятии, посвященном прибытию в город ковчега с частью мощей святителя Тихона, Патриарха Московского и всея России. Этот ковчег, прибывший в Казанский собор Санкт-Петербурга из Донского монастыря Москвы, является частью мероприятий, приуроченных к столетию блаженной кончины святителя. Встречу святыни возглавил митрополит Санкт-Петербургский и Ладожский Варсонофий. После прибытия мощей в соборе была совершена Божестве

В преддверии новогодних праздников социальные учреждения и стационары получат 10 тонн мандаринов

В преддверии новогодних праздников социальные учреждения и стационары Санкт-Петербурга получат в подарок 10 тонн мандаринов из Республики Абхазия. Эта благотворительная акция была инициирована политической партией «Народный Фронт Абхазии» и получила личную поддержку от Президента Республики Бадра Гунбы. Губернатор Санкт-Петербурга Александр Беглов отметил, что между Санкт-Петербургом и Абхазией существуют крепкие связи дружбы и взаимопомощи. Он подчеркнул, что абхазские школьники приезжают к ним

Состоялась торжественная церемония спуска на воду фрегата «Адмирал Амелько»

Сегодня, 14 августа, на судостроительном заводе «Северная верфь» состоялась торжественная церемония спуска на воду нового фрегата, получившего имя «Адмирал Амелько». В мероприятии приняли участие высокопоставленные лица: губернатор Санкт-Петербурга Александр Беглов, помощник Президента Российской Федерации Николай Патрушев, главнокомандующий Военно-Морским Флотом России Александр Моисеев и генеральный директор Объединенной судостроительной корпорации (ОСК) Андрей Пучков.

Петербург вышел на новый уровень строительства метро

Губернатор Александр Беглов принял участие в заседании Координационного совета, посвящённого развитию транспортной системы Санкт-Петербурга и Ленинградской области. Это мероприятие прошло сегодня, 17 декабря, в Смольном и было организовано заместителем председателя Правительства Российской Федерации Виталием Савельевым. В заседании также присутствовали министр транспорта Российской Федерации Андрей Никитин и генеральный директор – председатель правления ОАО «Российские железные дороги» Олег Бело

Александр Беглов поздравил ученика 11-го класса который победил Всероссийскую олимпиаду по искусственному интеллекту

Губернатор Санкт-Петербурга Александр Беглов поздравил Елисея Кирпиченко, ученика 11-го класса школы № 667, который стал абсолютным победителем Всероссийской олимпиады по искусственному интеллекту 2025 года, в которой также участвовали иностранные учащиеся. Результаты соревнования были объявлены накануне в Московском государственном техническом университете имени Н.Э. Баумана. Награды победителям и призёрам вручали заместитель председателя Правительства Российской Федерации Дмитрий Чернышенко и

В городе стартовал общегородской танцевальный марафон для людей «серебряного возраста»

Сегодня, 13 августа, в Санкт-Петербурге начался общегородской танцевальный марафон, предназначенный для людей «серебряного возраста». Это мероприятие проходит в рамках проекта «Городские танцевальные веранды» и стало уже четвертым по счету в текущем году. Марафон, который входит в программу «Серебряный возраст», охватывает 19 различных площадок, расположенных в разных районах города, с главной локацией в Юсуповском саду. Участники мероприятия могут посещать мастер-классы по различным танцевальны

Александр Беглов лично осмотрел место где произошла просадка дорожного полотна

Штаб был образован по указанию губернатора накануне, сразу после инцидента. В районе дома 29/20 по 1-му Муринскому проспекту произошло обрушение дорожного покрытия, связанное с работами шахты 120А Выборгского тоннельного коллектора. Глава города выразил благодарность федеральным и городским оперативным службам, включая работников жилищно-коммунального хозяйства, силовиков, медиков и спасателей МЧС, за их быструю реакцию и слаженные действия.

Александр Беглов посетил город-побратим Санкт‑Петербурга — Мариуполь

Сегодня губернатор Санкт-Петербурга Александр Беглов посетил город-побратим Мариуполь. Этот визит был приурочен к открытию восстановленного Драматического театра. В ходе своего выступления Александр Беглов отметил, что по указанию Президента России Владимира Владимировича Путина Санкт-Петербург начал процесс восстановления Мариуполя с первых дней его освобождения. 1 июня 2022 года Санкт-Петербург и Мариуполь официально стали городами-побратимами, а уже 4 июня 2022 года из Петербурга отправились

Александр Беглов вручил документы и ключи от новых квартир семьям защитников Родины

В торжественной обстановке, приуроченной ко Дню ветерана боевых действий, глава Санкт-Петербурга Александр Беглов лично передал свидетельства о праве собственности и ключи от новых квартир семьям военнослужащих, защищающих Родину. Среди получателей жилья оказались семьи тех, кто в настоящее время принимает участие в специальной военной операции и находится на передовой, мужественно сражаясь за безопасность нашей страны. В Санкт-Петербурге их ожидают близкие люди, с нетерпением ждущие возвращения

В честь 81-й годовщины окончания Ленинградской битвы состоялась торжественная церемония возложения цветов

В ознаменование 81-й годовщины окончания героической Ленинградской битвы, на площади Победы состоялась торжественная церемония возложения цветов к Монументу, посвященному мужественным защитникам Ленинграда. Участники церемонии почтили память погибших минутой молчания, отдавая дань уважения их самоотверженности и стойкости. Среди тех, кто возложил цветы, были полномочный представитель Президента Российской Федерации в Северо-Западном федеральном округе Александр Гуцан, губернатор Санкт-Петербурга

Город продолжает системную работу по оказанию социальной поддержки ветеранам

Сегодня в Смольном губернатор Санкт-Петербурга Александр Беглов провёл заседание Координационного совета по делам ветеранов города. В этом мероприятии приняли участие такие важные фигуры, как председатель правления Санкт-Петербургской общественной организации «Жители блокадного Ленинграда» Елена Тихомирова, председатель Совета Санкт-Петербургской общественной организации ветеранов (пенсионеров, инвалидов) войны, труда, Вооружённых сил и правоохранительных органов Василий Волобуев, а также другие

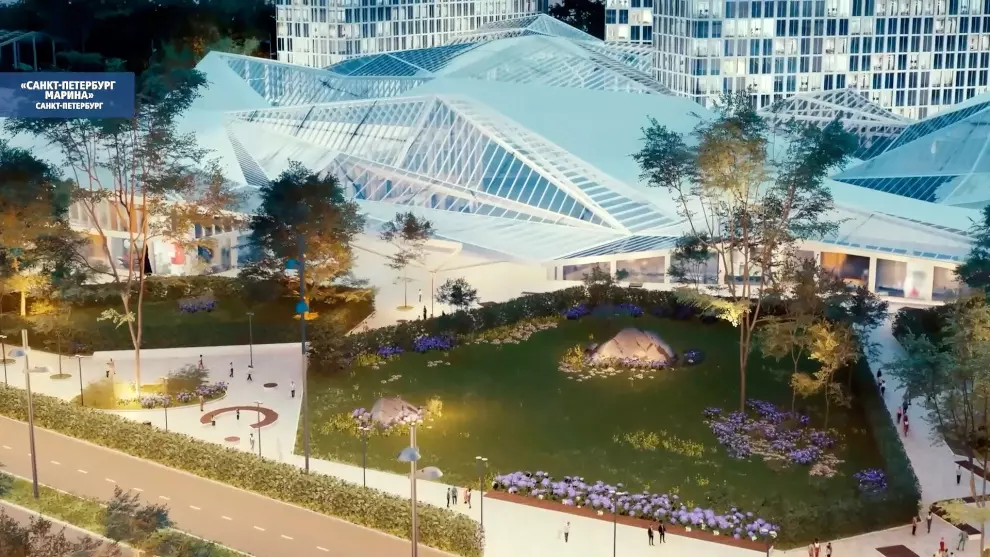

Всесезонный морской курорт «Санкт‑Петербург Марина» формируется по поручению Президента

Под председательством заместителя председателя Правительства Российской Федерации, Марата Хуснуллина, состоялось заседание президиума Правительственной комиссии по вопросам регионального развития. В ходе заседания были рассмотрены итоговые результаты конкурсного отбора инфраструктурных проектов, претендовавших на получение казначейских инфраструктурных кредитов (КИК). По результатам отбора был утвержден список проектов, которые получат финансирование за счет средств, привлекаемых посредством мех

Полностью завершены реставрационные работы в парадном вестибюле дома Пашкова

Завершены работы по реставрации в парадном вестибюле дома Пашкова, расположенного на Литейном проспекте. На свои прежние места вернулись две статуи зубров в натуральную величину, которые являются важным элементом оформления вестибюля. Специалисты с особой тщательностью восстановили уникальное многослойное покрытие скульптур, придающее гипсу цвет, схожий с настоящей бронзой. Губернатор Александр Беглов отметил, что сохранение исторического наследия и поддержка культуры находятся в числе десяти пр

Поддержку от города получили 4 предприятия

На заседании Совета городского Фонда содействия кредитованию малого и среднего бизнеса было принято решение о предоставлении поручительств четырем компаниям из Санкт-Петербурга на общую сумму 86,5 миллиона рублей. Это решение позволит этим предприятиям привлечь финансирование в размере 215 миллионов рублей. Поддержку от города получили компании, которые занимаются монтажом стальных строительных конструкций, торговлей электронным и телекоммуникационным оборудованием, а также оптовой и розничной п

Новый путепровод через железнодорожную линию Витебского направления в составе строящейся ЮШМ

В Пушкинском районе Санкт-Петербурга, в рамках возведения Южной широтной магистрали (ЮШМ), строительство нового путепровода над железнодорожными путями Витебского направления достигло 55-процентной готовности. Это наиболее протяженный из трех искусственных сооружений, создаваемых в рамках строительства дублера КАД, его длина составляет 346 метров. Глава Санкт-Петербурга Александр Беглов подчеркнул важность этого проекта для формирования транспортного каркаса города, отмечая, что ЮШМ не только сн

Город готов к отопительному сезону

На заседании городского правительства губернатор Александр Беглов сообщил о готовности инженерно-энергетического комплекса Санкт-Петербурга к отопительному сезону 2025-2026 годов. Он отметил, что предыдущий отопительный сезон прошёл без серьезных сбоев, все технологические нарушения устранялись в установленные сроки. В отличие от прошлых лет, когда подготовка к новому отопительному сезону начиналась в мае, в этом году работы стартовали в апреле с проведения температурных испытаний. Техническая г

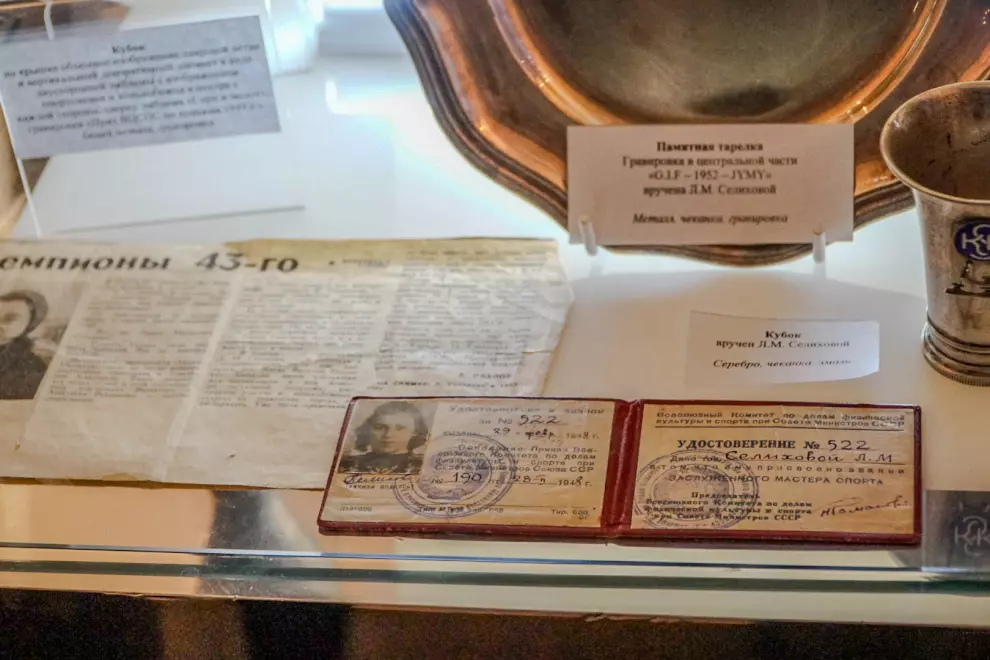

Число пользователей Единой карты петербуржца «Серебряный возраст» достигло 200 тысяч

Количество пользователей Единой карты петербуржца «Серебряный возраст» достигло отметки в 200 тысяч. На пленарном заседании XVIII Международного форума «Старшее поколение», проходящем в конгрессно-выставочном центре «Экспофорум», поздравления принимала обладательница юбилейной карты Ольга Харитонова. Эта ленинградская спортсменка, после выхода на пенсию, активно занимается воспитанием молодежи и управляет экспозицией, посвященной истории отечественного спорта, в одной из школ Санкт-Петербурга.

В канун Нового года энергетики переведены на режим повышенной готовности

В преддверии Нового года энергетические службы города переведены в состояние повышенной готовности. В этот период не планируется проводить работы на электрических сетях. Аварийно-восстановительные бригады, диспетчеры и специалисты по техническому обслуживанию будут работать по специальному графику. Также организовано дежурство руководящего состава, подготовлена специализированная техника, а также сформирован необходимый запас материалов для быстрого реагирования на возможные технологические сбои

Художественная подсветка Дворцового, Троицкого мостов и моста Бетанкура будет переведена в специальный режим

18 января, в день, когда отмечается прорыв блокады Ленинграда, художественная подсветка Дворцового, Троицкого мостов и моста Бетанкура будет переведена в специальный режим. Пролёты и опоры этих трёх переправ в Санкт-Петербурге будут освещены в цветах ленточки, символизирующей Ленинградскую Победу.

«Газпром» планирует построить новый стадион в городе

Губернатором Санкт-Петербурга Александром Бегловым подписан официальный документ Правительства Санкт-Петербурга, постановляющий передачу земельного участка под застройку спортивного объекта, расположенного по следующему адресу: Санкт-Петербург, Приморский район, внутригородское муниципальное образование, муниципальный округ Комендантский аэродром, улица Аккуратова, земельный участок с номером 7а.

Новое предприятия будет построено в Колпинском районе

На рабочем совещании губернатора Александра Беглова с членами правительства города были одобрены изменения в документации, касающейся планировки территории в промышленной зоне «Металлострой», расположенной в Колпинском районе. В этой зоне будет возведено предприятие, занимающееся производством труб большого диаметра. Изначально на данном участке планировалось построить только один объект производственного назначения, а также соответствующую коммунальную инфраструктуру. Однако теперь в проекте пр

В поликлинике № 17 на Бестужевской открыли кабинет мужского репродуктивного здоровья

В поликлинике номер 17, расположенной на Бестужевской улице, открылся первый кабинет мужского репродуктивного здоровья в Красногвардейском районе. Этот кабинет призван помочь в раннем выявлении различных заболеваний, включая серьезные недуги, такие как рак, а также подготовить мужчин к отцовству. Открытие данного отделения стало частью реализации проекта, поддержанного губернатором Александром Бегловым, который направлен на повышение осведомленности о значимости регулярных медицинских осмотров и

Ноябрь во всём мире традиционно считается месяцем мужского здоровья

Ноябрь во многих странах мира традиционно считается месяцем, посвящённым мужскому здоровью. В Санкт-Петербурге в медицинских учреждениях проходят мероприятия, целью которых является привлечение внимания к вопросам здоровья мужчин. Так, 12 ноября с 08:00 до 11:00 в Мариинской больнице мужчины в возрасте от 40 до 70 лет смогут по предварительной записи безвозмездно сдать анализ крови на простат-специфический антиген (ПСА) – это биомаркер, который помогает в диагностике рака предстательной железы.

В сквере имени Василия Маргелова состоялось возложение цветов к его памятнику

В день 95-летия Воздушно-десантных войск, 2 августа, у памятника генералу армии Василию Филипповичу Маргелову в сквере, носящем его имя, состоялась церемония возложения цветов. В этом торжественном мероприятии приняли участие представители власти города и региона – как исполнительной, так и законодательной ветвей. Среди присутствующих были руководитель Союза десантников России в Северо-Западном федеральном округе, президент Ассоциации имени Маргелова Александр Турков, военнослужащие, принимающие

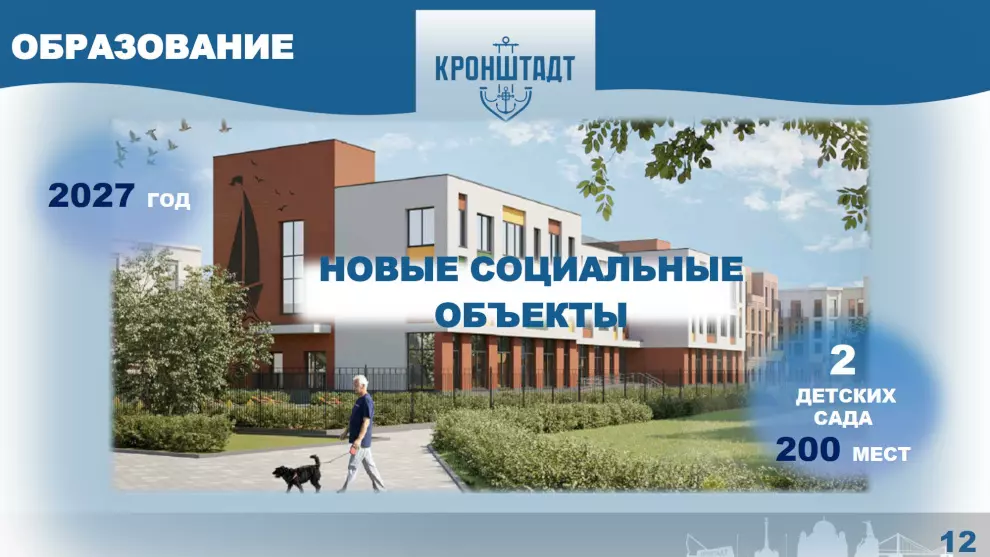

Кронштадт переживает самое масштабное преображение за свою историю

В торжественной обстановке губернатор Санкт-Петербурга Александр Беглов принял участие в церемонии открытия въездного знака, посвящённого присвоению Кронштадту почётного звания «Город воинской славы». Знак, установленный на главном въезде в город-крепость со стороны кольцевой автодороги (КАД), рядом с недавно отремонтированным участком Кронштадтского шоссе, представляет собой стилизованную носовую часть боевого корабля. Его облицовка выполнена из натурального гранита и хромированного металла. На

В Казанском соборе состоялось богослужение во имя Казанской иконы Божией Матери

Сегодня в Казанском соборе прошло торжественное богослужение в честь Казанской иконы Божией Матери. Этот день является престольным праздником главного храма Санкт-Петербурга. Божественную литургию возглавил митрополит Санкт-Петербургский и Ладожский Варсонофий, которому сослужили представители духовенства митрополии. На богослужении присутствовали такие высокопоставленные лица, как губернатор Санкт-Петербурга Александр Беглов, председатель Законодательного Собрания города Александр Бельский и за

70 лет Петербургскому метрополитену

Дорогие жители Санкт-Петербурга! Сегодня мы отмечаем 70-летие Ленинградского и Петербургского метрополитена. Это метро – не просто транспортная система, а настоящая легенда, символ нашей героической и трудовой истории. Планы по его строительству начали разрабатываться еще до войны. В 1941 году были заложены первые шахты, но все работы остановила война и блокада. Первые строители метро в осаждённом Ленинграде занимались возведением оборонительных сооружений и строительством портовых причалов на Д

Правительством РФ принято решение расширить комплексную государственную программу «Строительство»

Правительство Российской Федерации приняло решение о расширении комплексной государственной программы под названием «Строительство». В рамках этой программы был дополнительно утверждён ряд проектов, нацеленных на развитие культурной сферы и коммунальной инфраструктуры в Санкт-Петербурге. Для этих целей было выделено дополнительное финансирование. В обновлённый список включён проект по реставрации зданий, которые являются частью объекта культурного наследия федерального значения — «Дворец Великог

Завершился II Санкт‑Петербургский международный джазовый фестиваль

Второй Санкт-Петербургский международный джазовый фестиваль завершил свою работу. Мероприятие собрало более двухсот тысяч зрителей, посетивших 140 концертов, прошедших на девяти джазовых площадках, шести концертных площадках и, впервые в рамках фестиваля, на Джазовом параде. В фестивале приняли участие свыше шестисот музыкантов из России и других стран мира.

Александр Беглов принял участие в открытии XVIII Международного форума «Старшее поколение»

Сегодня губернатор Александр Беглов присутствовал на открытии XVIII Международного форума «Старшее поколение», который проходит в конгрессно-выставочном центре «Экспофорум». Этот форум является крупнейшей в России площадкой для разработки новых подходов в социальной работе, направленных на улучшение условий жизни пожилых людей. В этом году мероприятие собрало 2500 специалистов из социальной сферы, представляющих 37 регионов России, а также гостей из Республики Беларусь.

Суворовское военное училище отмечает сегодня 70-летие со дня основания

Сегодня Санкт-Петербургское суворовское военное училище торжественно отмечает семидесятую годовщину со дня своего основания. В честь этого знаменательного события Губернатор Санкт-Петербурга Александр Беглов направил тёплые слова поздравлений руководству, преподавательскому составу, воспитанникам и всем выпускникам училища. В своём поздравлении Александр Беглов подчеркнул, что это известное и уважаемое учебное заведение заслуженно гордится своими выпускниками, которые с честью и доблестью носят

Знак «Жителю блокадного Ленинграда», статус ветерана и соответствующие меры поддержки получат все кто провёл в осаждённом городе

Сегодня перед началом заседания городского правительства губернатор Александр Беглов сообщил о важных изменениях, касающихся знака «Жителю блокадного Ленинграда». Ранее этот знак могли получить лишь те, кто прожил в блокадном Ленинграде не менее четырех месяцев. Однако вносимые изменения расширяют возможность получения льгот для блокадников. Инициатива о внесении этих изменений была предложена организацией «Жители блокадного Ленинграда» и получила поддержку от Президента Российской Федерации.

Продолжается работа по развитию сети «серебряных центров»

На сегодняшнем заседании городского правительства Санкт-Петербурга были обсуждены итоги реализации второго этапа Стратегии действий в интересах граждан старшего поколения в Российской Федерации за 2024 год, а также намечены задачи на 2025 год. Губернатор Александр Беглов напомнил о том, что данная Стратегия была принята по инициативе Президента России и является главным руководством в вопросах обеспечения прав и социальной поддержки пожилых людей, а также создания условий для здорового и активно

В городе пройдет III Фестиваль стран Латинской Америки

В Санкт-Петербурге сегодня состоится торжественное открытие третьего по счёту Фестиваля стран Латинской Америки. Место проведения этого масштабного мероприятия – живописный Юсуповский сад, расположенный на Садовой улице. В церемонии открытия примут участие высокопоставленные представители дипломатических миссий. Среди них – руководители посольств Кубы, Коста-Рики и Колумбии, а также официальные лица из дипломатических представительств Доминиканской Республики, Парагвая и Перу, включая почётных к

Петербургских автомобилистов не будут привлекать к ответственности за неоплату парковки из-за БПЛА в День ВМФ

После завершения празднования Дня Военно-Морского Флота в Санкт-Петербурге, Александр Беглов выразил признательность сотрудникам правоохранительных органов и городских коммунальных служб за их участие в обеспечении безопасности города и Ленинградской области от атак беспилотных летательных аппаратов, произошедших 27 июля. Губернатор особо отметил, что силовые структуры и городские службы предприняли все необходимые действия для минимизации последствий самой масштабной на тот момент атаки беспило

Определен порядок выплат семьям на погашение ипотеки

Губернатор Санкт-Петербурга Александр Беглов подписал новое постановление Правительства города, которое вносит изменения в ранее принятое постановление от 22 мая 2013 года под номером 343. Данный документ устанавливает порядок предоставления новой дополнительной меры социальной поддержки для семей с детьми. Эта мера подразумевает погашение обязательств по ипотечным жилищным кредитам на сумму до 550 тысяч рублей.

Губернатор поблагодарил пожарных и спасателей за их нелегкий труд

Сегодня, 18 декабря, губернатор Александр Беглов провел встречу в Смольном с участниками итогового сбора, посвященного подведению результатов работы Санкт-Петербургской территориальной подсистемы единой государственной системы предупреждения и ликвидации чрезвычайных ситуаций за 2025 год. От имени всех жителей города он выразил благодарность пожарным и спасателям за их тяжелый труд. «В этом уходящем году мы осуществили значимую совместную деятельность. Нам удалось справиться с множеством сложных

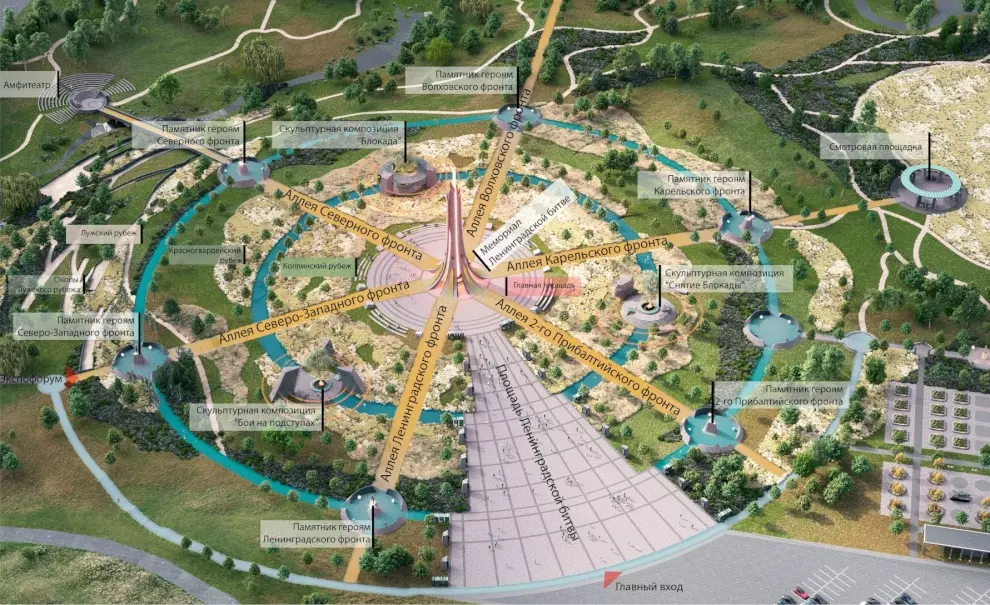

Продолжается подготовка к возведению монумента участникам Ленинградской битвы

В Пушкинском районе Санкт-Петербурга продолжается подготовка к сооружению монумента, посвященного участникам Ленинградской битвы. Важным этапом организационной работы стало определение музея, который будет управлять этим мемориальным комплексом. Выбор пал на Музей истории Санкт-Петербурга. Губернатор Санкт-Петербурга Александр Беглов подчеркнул значимость этого проекта, отметив, что Ленинградская битва, длившаяся более трех лет и являющаяся самым продолжительным сражением Великой Отечественной в

88 лет со дня рождения первого мэра Санкт‑Петербурга

Десятое августа ознаменовалось 88-й годовщиной со дня рождения Анатолия Александровича Собчака, первого мэра Санкт-Петербурга. В этот памятный день, посвящённый жизни и деятельности выдающегося государственного деятеля, представители правительства Санкт-Петербурга почтили его память, возложив цветы к месту его захоронения в Александро-Невской лавре. Кроме того, цветочная композиция от правительства Санкт-Петербурга была установлена у монумента, посвященного Анатолию Собчаку, расположенного на Ва

В Петроградском районе завершён проект строительства нового канализационного коллектора

В Петроградском районе Санкт-Петербурга завершился проект по строительству нового канализационного коллектора и реконструкции систем водоотведения на Петровском острове. В результате проведённых работ были полностью устранены прямые сбросы сточных вод в реки Ждановку и Малую Неву. Теперь все сточные воды направляются на Северную станцию аэрации. Губернатор Александр Беглов подчеркнул, что Петровский остров является центром Петербурга, и впервые здесь обеспечена 100-процентная очистка хозяйственн

В Смольном состоялось совместное заседание Антитеррористической комиссии

Сегодня, 22 июля, в здании Смольного под руководством губернатора Санкт-Петербурга Александра Беглова состоялось совместное заседание Антитеррористической комиссии Санкт-Петербурга и городского Оперативного штаба. В работе заседания участвовали члены Антитеррористической комиссии, представители руководства федеральных и региональных органов исполнительной власти, сотрудники правоохранительных органов, а также представители коммерческих организаций.

Трамвайное депо линии «Купчино – Шушары – Славянка» принимает первые десять вагонов

В строящемся трамвайном депо в посёлке Шушары, предназначенном для обслуживания линии «Купчино – Шушары – Славянка», началась приемка первых десяти трамвайных вагонов. В течение ближайшей недели с Невского завода электрического транспорта имени А.Ф. Пироцкого будет доставлена вся партия. Эти вагоны будут курсировать по маршруту от станции метро «Купчино» до самого депо. Для линии «Славянка» выбран трёхсекционный трамвай модели 71-932 «Невский», способный двигаться в обе стороны. Учитывая длину в

У СПбГМТУ открылось новое общежитие

В торжественной церемонии открытия нового общежития Санкт-Петербургского государственного морского технического университета (СПбГМТУ), расположенного на Ленинском проспекте, приняли участие высокопоставленные лица: помощник Президента Российской Федерации, председатель Морской коллегии РФ Николай Патрушев, министр науки и высшего образования Валерий Фальков, полномочный представитель Президента РФ в Северо-Западном федеральном округе Александр Гуцан и губернатор Санкт-Петербурга Александр Бегло

Город продолжает получать школы и детские сады по «петербургскому стандарту»

В преддверии Дня знаний глава Санкт-Петербурга, Александр Беглов, посетил новый корпус школы №635, расположенной на Плесецкой улице, с целью проверки готовности учебного заведения к началу нового учебного года. В ходе визита он обратил внимание на то, что Приморский район, являющийся наиболее густонаселённым районом города, характеризуется интенсивным жилищным строительством. В связи с этим, в ближайшие дни в школы района пойдут около семидесяти тысяч школьников. К 1 сентября в Приморском районе

Александр Беглов представил доклад Президенту РФ о визите в Республику Узбекистан

Александр Беглов, занимающий пост губернатора, представил доклад Президенту Российской Федерации Владимиру Путину, в котором подробно осветил результаты визита делегации, представляющей Санкт-Петербург, в Республику Узбекистан. В своем докладе губернатор акцентировал внимание на расширении и укреплении партнерских связей между Санкт-Петербургом и Узбекистаном в различных областях, включая экономику, здравоохранение, научные исследования, систему высшего образования, индустрию туризма и другие на

В ежегодной новогодней акции Горэлектротранса „Волшебный трамвай“ участвуют новейшие трамваи „Витязь-М“ и троллейбусы

В Трамвайном парке номер 8 губернатор Александр Беглов провёл осмотр нового подвижного состава, который был передан в Горэлектротранс для эксплуатации на городских маршрутах. В компании воспитанников ведомственного лагеря «Зарница» он отдал команду включить новогоднюю иллюминацию на трамвайных вагонах, троллейбусе и трамвае-пикапе.

Делегация из Петербурга осмотрела место строительства квартала «Санкт‑Петербург» в Новом Ташкенте

В рамках официального визита в Республику Узбекистан губернатор Санкт-Петербурга Александр Беглов вместе с членами петербургской делегации посетил место, где будет возводиться квартал под названием «Санкт-Петербург» в строящемся городе Новый Ташкент. На месте будущего строительства состоялась встреча с высокопоставленным представителем узбекского правительства – заместителем министра строительства и жилищно-коммунального хозяйства Республики Узбекистан, а также директором Дирекции, отвечающей за

Делегация Правительства Петербурга начала официальный визит в Республику Куба

Делегация Правительства Санкт-Петербурга, возглавляемая губернатором Александром Бегловым, сегодня начала официальный визит в Республику Куба. В рамках этого визита глава города планирует посетить провинции Гавана, Матансас и Сантьяго-де-Куба, которые пострадали от урагана «Мелисса». Санкт-Петербург поддерживает побратимские отношения с Сантьяго-де-Куба, столицей одной из этих провинций.

На Большом Смоленском мосту стартовал новый этап строительных работ

На Большом Смоленском мосту стартовал новый этап строительных работ. Специалисты компании АО «Дороги и Мосты» НПС начали установку «крыльев» будущей переправы. В день, когда отмечается 175-летие со дня открытия первого постоянного разводного моста через Неву — Благовещенского моста, мостостроители приступили к важному этапу строительства Большого Смоленского моста, начав монтаж двукрылого разводного пролета. Разводные мосты являются неотъемлемой частью архитектурного облика Северной столицы, и в

Участники специальной военной операции побывали на экскурсии по новогоднему городу

Участники специальной военной операции, находящиеся на лечении в Городской больнице Святого Великомученика Георгия, отправились на автобусную экскурсию по новогоднему Санкт-Петербургу. Это мероприятие было организовано по приглашению губернатора Александра Беглова, который встретился с бойцами в минувшую пятницу.

10 лучших руководителей государственных образовательных учреждений будут награждены

Губернатор Санкт-Петербурга Александр Беглов утвердил распоряжение Правительства города о вручении премии «Лучший руководитель государственного образовательного учреждения Санкт-Петербурга» за 2025 год.

Александр Беглов посетил выставку «Сильный, державный…» в Михайловском замке

Сегодня губернатор Александр Беглов посетил выставку под названием «Сильный, державный», которая проходит в Михайловском замке – филиале Государственного Русского музея. Эта выставка является первой частью обширного проекта, посвященного «Эпохе Императора Александра III и её наследию», и продолжает серию мероприятий, приуроченных к юбилею императора, 180-летие со дня рождения которого отмечалось в прошлом году. В рамках выставки в Михайловском замке представлено более 500 уникальных экспонатов,

В городе разработан комплексный план мероприятий по оздоровлению гидросистемы Суздальских озер

В Санкт-Петербурге разработан всеобъемлющий план мероприятий, направленный на улучшение экологического состояния системы Суздальских озер. В настоящий момент завершается этап инженерных изысканий и создание проектной документации. Глава города, Александр Беглов, подчеркнул значимость Суздальских озер не только как популярной зоны отдыха для петербуржцев, но и как одной из крупнейших гидросистем города, испытывающей в настоящее время существенное антропогенное воздействие, усугубляемое влиянием и

Определены победители конкурса детского рисунка «Мы – за чистоту»

Сегодня, 25 октября, губернатор Санкт-Петербурга Александр Беглов провел церемонию награждения победителей конкурса детского рисунка под названием «Мы – за чистоту». Это мероприятие было приурочено к началу акции «Добрый субботник», которая проходит в рамках общегородского Дня благоустройства. Праздник состоялся в Парке 300-летия Санкт-Петербурга.

Стартовал заключительный этап Всероссийского конкурса «Учитель года России»

В Смольном дворце состоялась торжественная церемония открытия заключительного этапа Всероссийского конкурса «Учитель года России – 2025», в которой приняли участие губернатор Санкт-Петербурга Александр Беглов и заместитель министра просвещения Российской Федерации Ирина Шварцман. Это 36-й по счёту конкурс, на заключительном этапе которого соревнуются 89 победителей региональных отборов, представляющие каждый субъект Российской Федерации.

Масштабную программу подготовили к 83-й годовщине прорыва блокады Ленинграда и 82-й годовщине полного освобождения города

Организация общегородских мероприятий, посвящённых 83-й годовщине прорыва блокады Ленинграда и 82-й годовщине полного освобождения города от фашистской блокады, стала центральной темой заседания Координационного совета по делам ветеранов Санкт-Петербурга. Это заседание прошло сегодня в Смольном под руководством губернатора Александра Беглова. Он отметил, что в конце прошлого года был утверждён план мероприятий на январь, который оказался весьма насыщенным, и город готов к его реализации. Губерна

Новая улица появится в Московском районе

На сегодняшнем рабочем совещании губернатора Александра Беглова с представителями городского правительства был утверждён проект планировки и межевания территории для возведения новой улицы в Московском районе. Данная улица, которая временно именуется Магистраль 2, будет иметь протяжённость около двух километров и состоять из четырёх полос движения. Она начнётся от Пулковского шоссе и будет проходить до проезда 6. В рамках проекта также предусмотрены тротуары и велодорожка, что обеспечит удобство

Петербург всегда был и остаётся образцом единения граждан

Сегодня в Смольном губернатор Санкт-Петербурга Александр Беглов провёл заседание Консультативного совета, который занимается вопросами межнациональных и межрелигиозных отношений. На встрече были подведены итоги работы за год по реализации государственной национальной политики в городе, а также определены задачи на 2026 год, который Президент России объявил Годом единства народов.

Уникальный социальный кластер откроется в Курортном районе

Сегодня губернатор Александр Беглов посетил Дом социального обслуживания «Парус», который предназначен для детей с ограниченными возможностями здоровья, требующих постоянного ухода. Это учреждение находится в посёлке Ушково, расположенном в Курортном районе. В «Парусе» проживают 70 детей в возрасте от 4 до 18 лет. Глава города поздравил детей и сотрудников с наступающим Новым годом и Рождеством, принял участие в новогоднем празднике и осмотрел выставку поделок, выполненных воспитанниками.

Завершена масштабная модернизация наружного освещения на двухкилометровом участке улицы Савушкина

В Санкт-Петербурге завершилась значительная модернизация наружного освещения на участке улицы Савушкина, протяжённостью два километра — от Приморского шоссе до Западного скоростного диаметра. Губернатор города Александр Беглов отметил, что Петербург на сегодняшний день является лидером в области обновления уличного освещения. За последние несколько лет в городе было заменено 63 процента всех светильников на современные светодиодные.

Стартовала Неделя сокращения потребления алкоголя

Сегодня в Санкт-Петербурге началась Неделя, посвященная сокращению потребления алкоголя, а также снижению связанной с ним смертности и заболеваемости. Это мероприятие приурочено ко Всероссийскому дню трезвости, который отмечается 11 сентября. С 8 по 14 сентября в городских средствах массовой информации и социальных сетях будут публиковаться материалы, посвященные борьбе с алкоголизмом. В рамках этой недели планируются интервью и выступления врачей-наркологов, мнения ведущих экспертов, а также ре

Компания «Зенит-Арена» возвела спортивный центр с современным оборудованием и тренажёрами

Губернатор Санкт-Петербурга Александр Беглов во время своей инспекции спортивных объектов Приморского района посетил новую спортивную площадку, расположенную рядом с Парком 300-летия Санкт-Петербурга, предназначенную для сдачи норм ГТО. В этом мероприятии также участвовал Председатель Законодательного Собрания Санкт-Петербурга Александр Бельский. Строительная компания «Зенит-Арена» создала на этом участке полноценный спортивный центр, оснащенный современным оборудованием и тренажерами. В настоящ

На севере города продолжается активное строительство трассы М-32

На северной стороне Санкт-Петербурга продолжается активное возведение трассы М-32. Основные строительные работы сосредоточены на создании будущей транспортной развязки с Приморским шоссе в районе Лахта-центра. В настоящее время выполнено 50% опор путепровода и 25% подпорных стен. В целом уровень готовности всего объекта составляет 20%. Для создания путепроводной развязки петербургские строители возводят 23 монолитные железобетонные опоры, высота которых варьируется от 4 до 11 метров, из которых

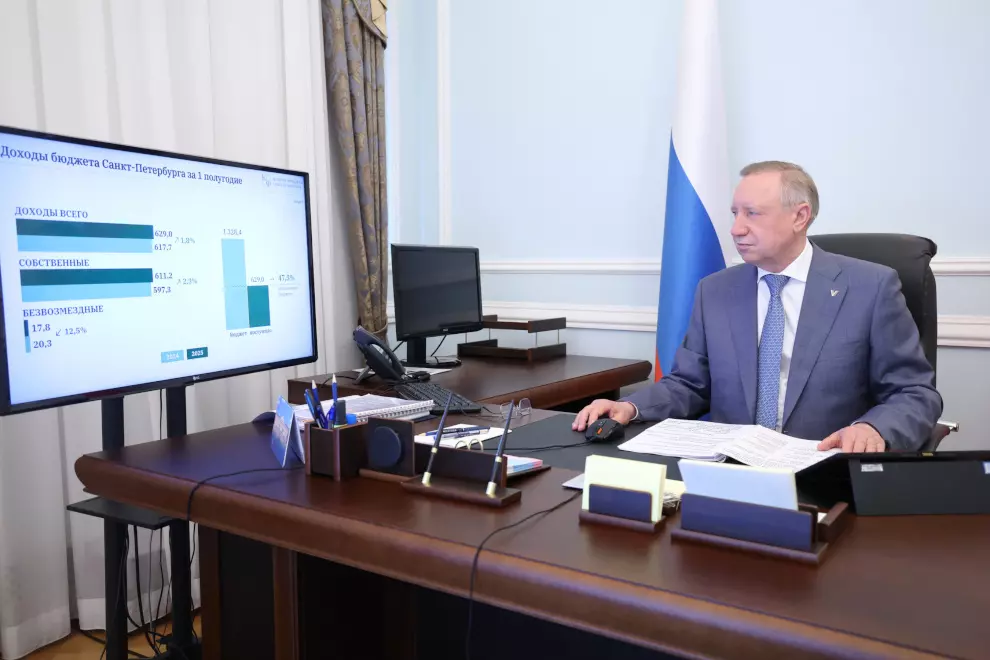

Широтная магистраль скоростного движения – ключевой объект транспортного каркаса

Сегодня, 29 октября, губернатор Санкт-Петербурга Александр Беглов представил депутатам Законодательного Собрания проект бюджета города на 2026-2028 годы в первом чтении. В ходе своего выступления он подчеркнул, что среди крупных проектов, реализуемых в Петербурге, особое внимание уделяется объектам транспортной инфраструктуры, таким как Широтная магистраль скоростного движения и Большой Смоленский мост.

Метрополитен отмечает 70-летие

Сегодня метрополитен Северной столицы отмечает свой 70-летний юбилей. 15 ноября 1955 года на первом пусковом участке первой линии начали курсировать первые поезда. В честь этого события город организует множество мероприятий, которые будут интересны петербуржцам всех возрастов. Основные события праздничной программы стартовали на станции метро «Площадь Восстания», которая в 1955 году завершала первый участок первой линии.

В городе вновь пройдет традиционный фестиваль «Ленинградские мосты»

В Санкт-Петербурге вновь пройдет традиционный фестиваль «Ленинградские мосты». В этом году у него появится новая сцена — куртина, расположенная у Кронверского бастиона Петропавловской крепости. Юбилейный, десятый по счету, фестиваль запланирован на период с 22 по 24 августа. Музыкальные выступления будут организованы на четырех различных сценах. Кроме новой площадки у Кронверкского бастиона, звуки музыки будут звучать и на привычных местах проведения фестиваля: на Банковском, Мучном и Мало-Конюш

В городе проходит XI Международный онкологический форум «Белые ночи 2025»

В Санкт-Петербурге, Северной столице России, проходит одиннадцатый Международный онкологический форум «Белые ночи 2025», на котором собрались ведущие специалисты в области онкологии со всего мира. Губернатор Санкт-Петербурга Александр Беглов обратился к участникам форума с приветственной речью, особо отметив значимость Санкт-Петербурга как ключевого центра для проведения передовых медицинских обсуждений и обмена опытом. В своём выступлении глава города подчеркнул, что Санкт-Петербург традиционно

В День семьи, любви и верности губернатор вручил награды многодетным семьям

В День семьи, любви и верности, который отмечался сегодня, губернатор Санкт-Петербурга Александр Беглов провел торжественную церемонию награждения многодетных семей города. В Смольном состоялось вручение государственных наград и ключей от пассажирских микроавтобусов. Обращаясь к собравшимся, Александр Беглов подчеркнул, что многодетные семьи являются примером воплощения традиционных ценностей, демонстрируя любовь, доброту, терпение и мужество в воспитании детей. Он упомянул слова Президента Росс

Александр Беглов дал старт традиционной новогодней благотворительной акции «Дерево желаний»

На этой неделе губернатор Санкт-Петербурга Александр Беглов инициировал традиционную новогоднюю благотворительную акцию под названием «Дерево желаний». С праздничной ёлки, установленной в Смольном, он снял три открытки, написанные детьми из Петербурга. В частности, 10-летний Ярослав, проживающий в Фрунзенском районе, выразил желание получить тренажер для бокса. 13-летний Денис из Красногвардейского района мечтает о игрушечном танке, а 8-летняя Арина из Центрального района хотела бы получить твор

Во Всемирный день мозга состоялось открытие Городского центра дегенеративных заболеваний

В Санкт-Петербурге, в ознаменование Всемирного дня мозга, состоялось торжественное открытие Городского центра дегенеративных заболеваний и ботулинотерапии. Центр функционирует на базе 81-й поликлиники, расположенной в Адмиралтейском районе города. Губернатор Санкт-Петербурга Александр Беглов, комментируя это событие, отметил, что открытие Центра является наглядной демонстрацией комплексного подхода к развитию городской медицины, в рамках приоритетного направления «Здоровье петербуржцев». По его

В рамках проекта «Комфортная городская среда Санкт-Петербурга» запланировано благоустройство территории

В рамках городского проекта «Комфортная городская среда Санкт-Петербурга» запланировано благоустройство территории вдоль проспекта Крузенштерна на искусственно созданных участках Васильевского острова. Четыре участка, расположенные в этой зоне, включены в официальный реестр городских зелёных насаждений общего пользования, предназначенных для создания скверов. Работы по проектированию этих скверов начнутся в текущем году.

С помощью Дорожного фонда город приступает к строительству новых этапов ШМСД

В ходе сегодняшнего рабочего совещания губернатора Санкт-Петербурга Александра Беглова с членами городского правительства был утвержден порядок формирования и использования бюджетных средств Дорожного фонда Санкт-Петербурга на ближайшие три года. Общий объем финансирования Дорожного фонда на этот период определен в размере 380 миллиардов рублей. На 2025 год запланировано выделение 135 миллиардов рублей, что составляет 9% от всех расходов городского бюджета и приблизительно половину всех затрат н

Продолжается строительство нового транспортного каркаса

Строительство нового транспортного каркаса на севере Санкт-Петербурга продолжается. В данный момент стартовала вторая очередь переустройства Приморского шоссе на участке, где оно пересекается с магистралью М-32 в районе Лахта-центра. Здесь возводится двухуровневая путепроводная развязка. Губернатор Александр Беглов отметил, что «Проект магистрали М-32 реализуется в рамках одного из десяти приоритетов развития Санкт-Петербурга, а именно - «Удобный общественный транспорт». Данная магистраль, длино

Петербург гордится тем, что в третий раз становится столицей чемпионата «Профессионалы»

В дни открытия и закрытия финала чемпионата по профессиональному мастерству «Профессионалы» филиал РТРС «Санкт-Петербургский региональный центр» организует праздничную архитектурно-художественную подсветку на телебашне Санкт-Петербурга. Цветовая палитра будет выполнена в официальных цветах чемпионата — белом и зеленом. Подсветка будет активирована на телебашне 29 ноября и 4 декабря, начиная с 16:10 и продолжая до 09:30 следующего дня.

У инвестора будет выкуплено трехэтажное здание для размещения детского сада №29 Курортного района

Губернатор Санкт-Петербурга Александр Беглов подписал постановление, касающееся бюджетных инвестиций, которое касается приобретения нежилого здания в государственную собственность Санкт-Петербурга. Это здание расположено по адресу: Санкт-Петербург, поселок Песочный, улица Ленинградская, дом 53, корпус 2, строение 1. Инвестор планирует выкупить трехэтажное здание с общей площадью 2 433 квадратных метра для организации в нем детского сада номер 29, который будет находиться в Курортном районе город

В Петербурге началась реставрация объекта культурного наследия федерального значения

В Санкт-Петербурге начались масштабные реставрационные работы на объекте культурного наследия федерального значения – Большой Хоральной Синагоге. Ремонтные мероприятия, финансируемые из городского бюджета в рамках программы Комитета по государственному контролю, использованию и охране памятников истории и культуры (КГИОП), охватывают фасады и кровлю здания. Завершение всех работ запланировано на конец 2027 года.

Сбербанк начали приём заявлений и выпуск детской карты «ЕКПшки»

С первого сентября 2025 года ПАО «Сбербанк России» начал принимать заявления на выпуск и выдавать детские карты «Единая карта петербуржца», которые в обиходе называют «ЕКПшками». Другие банки, имеющие право выпускать карты, присоединятся к процессу по мере завершения необходимых технических работ. Получить «ЕКПшку» может любой ребенок, являющийся гражданином Российской Федерации. Подобно взрослой версии карты, детская карта построена на базе платежной системы «Мир».

Губернатор принял участие в установке закладного камня на месте будущего памятника мастеру в Ораниенбаумском саду

Сегодня, 15 сентября, в день столетия со дня рождения знаменитого актера Кирилла Лаврова, губернатор Санкт-Петербурга Александр Беглов принял участие в торжественной церемонии закладки камня на месте будущего памятника этому выдающемуся мастеру в Ораниенбаумском саду, расположенном в Петроградском районе. На мероприятии присутствовали дочь Кирилла Лаврова, Мария, его внучка Ольга и годовалая правнучка Ксения, а также сотрудники БДТ и местные жители.

В Выборгском районе продолжаются работы по ликвидации просадки грунта

В Выборгском районе продолжаются работы по устранению просадки грунта на участке коллектора, расположенном на улице Харченко, между домами 18 и 20/29 по 1-му Муринскому проспекту. По указанию губернатора Александра Беглова, который возглавляет оперативный штаб, занимающийся ликвидацией данного технологического нарушения, к анализу причин возникновения просадки и поиску наиболее эффективных решений были привлечены ведущие специалисты из Санкт-Петербурга. В частности, в проект вовлечены геодезисты

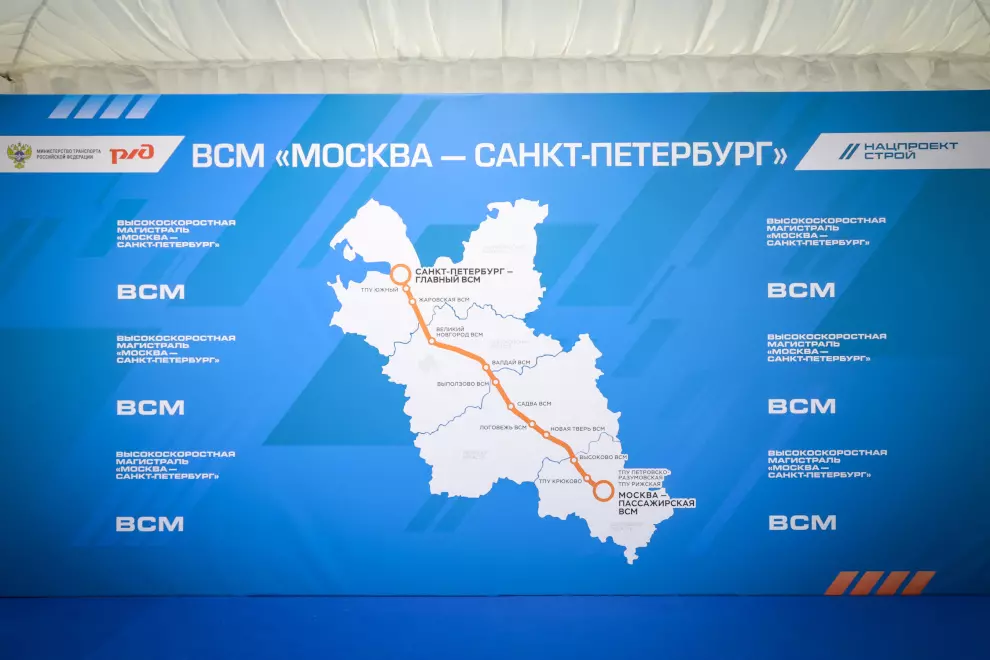

ВСМ – стратегический проект для Санкт‑Петербурга

Сегодня в Смольном губернатор Санкт-Петербурга Александр Беглов провёл рабочую встречу с Виталием Савельевым, заместителем председателя Правительства Российской Федерации. Основным предметом обсуждения стали ключевые транспортные проекты, реализуемые в Петербурге. Одной из центральных тем встречи стало строительство объектов Высокоскоростной железнодорожной магистрали (ВСМ) на территории Северной столицы. Губернатор подчеркнул, что проект ВСМ является стратегически важным для Санкт-Петербурга и

Проект планировки для размещения второй нитки Главного канализационного коллектора был утвержден

Сегодня, в ходе рабочего совещания губернатора Александра Беглова с членами правительства города, был утвержден проект планировки территории для строительства второй нитки Главного канализационного коллектора, который будет размещен в северной части Санкт-Петербурга. Губернатор отметил важность данного объекта для города, указав на то, что действующий коллектор находится в эксплуатации с 1980-х годов. Введение второй нитки позволит перенаправить на неё сточные воды и провести комплексное обследо

На путепроводе трамвайной линии «Купчино – Шушары – Славянка» установлены все опоры контактной сети

На путепроводе трамвайной линии «Купчино – Шушары – Славянка», который пересекает КАД, железную дорогу и Московское шоссе, завершена установка всех опор контактной сети. Также полностью подготовлена плита, на которую будут укладываться рельсы. Общая длина этого путепровода составляет 1,2 километра, из которых 240 метров занимает пролётное строение над КАД. Данный объект является важнейшим элементом всей рельсовой магистрали.

В рамках нацпроекта «Семья» созданы и открыты Пункты проката предметов первой необходимости для новорождённых

В Санкт-Петербурге, в рамках национального проекта «Семья» и городской программы по увеличению рождаемости на 2024-2027 годы, по инициативе губернатора Александра Беглова были созданы и открыты Пункты проката предметов первой необходимости для новорожденных. Эти пункты начали функционировать во всех районах города на базе Центров социальной помощи семье и детям, а также при Санкт-Петербургском государственном бюджетном учреждении «Кризисный центр помощи женщинам».

Высокоскоростная железнодорожная магистраль — ключевой проект для Петербурга и всей страны

Сегодня, 6 ноября, губернатор Санкт-Петербурга Александр Беглов провел личный прием граждан на базе регионального отделения партии «Единая Россия». На мероприятии также присутствовал Секретарь Санкт-Петербургского регионального отделения этой партии, Александр Бельский. В ходе приема губернатор ответил на вопросы жителей города. Одними из первых вопросов, которые были адресованы главе города, касались строительства высокоскоростной магистрали, соединяющей Санкт-Петербург и Москву. Один из жителе

В 2026 году минимальная зарплата в Петербурге увеличится почти на 9 %

Сегодня, 11 декабря, в Смольном состоялась церемония подписания Регионального соглашения о минимальной заработной плате (МРОТ) в Санкт-Петербурге на 2026 год. Подписи под документом поставили губернатор Александр Беглов, первый вице-президент и генеральный директор исполнительной дирекции Союза промышленников и предпринимателей Санкт-Петербурга Михаил Лобин, а также председатель Ленинградской Федерации Профсоюзов Александр Голубев.

Александр Беглов рассказал Президенту России о развитии социальной сферы Петербурга

В ходе двусторонней встречи, состоявшейся 26 января, Александр Беглов проинформировал Президента России о прогрессе в социальной сфере Санкт-Петербурга, охватывающем систему здравоохранения, поддержку семей с детьми и людей пожилого возраста.

«Алые паруса» прошли с большим успехом

В ходе рабочего совещания с представителями городской администрации губернатор Санкт-Петербурга Александр Беглов выразил признательность своим коллегам и всем участникам подготовки и проведения традиционного городского торжества для выпускников – фестиваля «Алые паруса».

День ветерана боевых действий

Дорогие жители Санкт-Петербурга! 1 июля наша страна и наш любимый город отмечают День ветерана боевых действий. Мы испытываем глубокое чувство гордости за наших воинов и выражаем искреннюю благодарность за их беспримерный героизм, проявленный во имя нашей безопасности и мирной жизни. Они защищали интересы России, часто вдали от дома, в крайне сложных и опасных условиях. Десятки тысяч петербуржцев и граждан России сражались за нашу страну на Ближнем Востоке, в Юго-Восточной Азии, в южной части Аф

В городе традиционно проходит акция «СТОП диабет»

В честь Всемирного дня борьбы с диабетом, который отмечается сегодня, в Санкт-Петербурге традиционно проходит акция под названием «СТОП диабет». Жители города имеют возможность бесплатно проверить уровень глюкозы в крови и получить консультации от специалистов. Мероприятия организованы в поликлиниках, расположенных в Невском, Приморском, Московском, Василеостровском, Фрунзенском, Кировском, Калининском, Красногвардейском, Адмиралтейском, Петроградском, Колпинском, Курортном и Кронштадтском район

Во всех поликлиниках города подготовлен к запуску проект «Здоровье для СВОих»

В Санкт-Петербурге во всех поликлиниках готов к внедрению проект под названием «Здоровье для СВОих», направленный на организацию расширенной диспансеризации для ветеранов боевых действий, участников специальной военной операции. Губернатор Александр Беглов подчеркнул, что забота о защитниках Родины, с честью выполнивших свой воинский долг в ходе специальной военной операции, является не только моральным обязательством, но и одной из важнейших задач, поставленных Президентом страны. Возвращение у

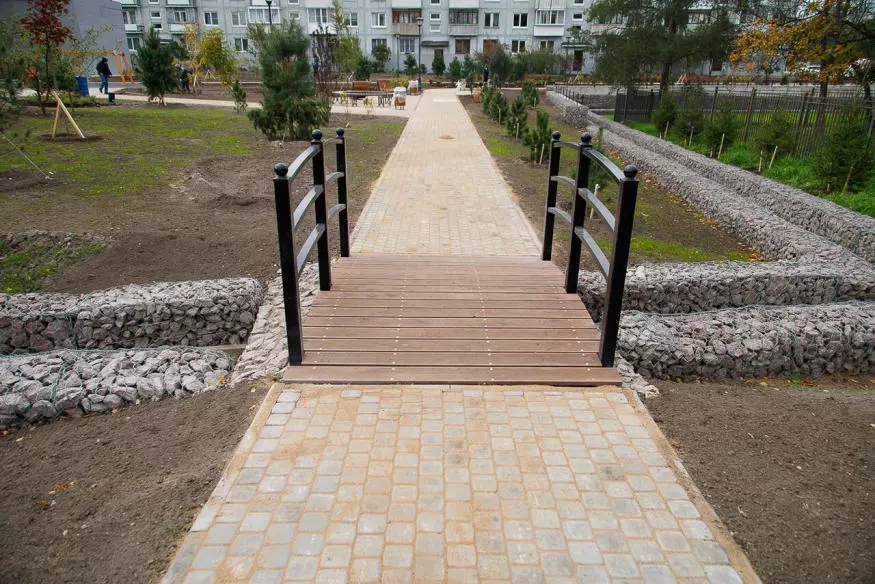

В Пушкинском районе в рамках проекта «ИТМО Хайпарк» сдан первый участок теплотрассы

В Пушкинском районе Санкт-Петербурга, в рамках масштабного проекта «ИТМО Хайпарк», успешно завершен первый этап строительства тепловой магистрали. Проложенный участок теплотрассы оснащен высококачественными трубами отечественного производства. На месте бывшего котлована благоустроена территория: созданы зелёные насаждения, проложены удобные пешеходные и велосипедные дорожки. Полное завершение работ по строительству тепловой магистрали планируется до конца текущего года. Параллельно началось стро

В городе расширен перечень видов высокотехнологичной медицинской помощи

Губернатор Санкт-Петербурга Александр Беглов подписал постановление, касающееся проекта Закона Санкт-Петербурга, который касается Территориальной программы государственных гарантий бесплатного предоставления медицинской помощи гражданам в Санкт-Петербурге на 2026 год, а также на плановый период 2027 и 2028 годов. В 2026 году общий объем данной программы составит 309 миллиардов рублей, что на 19 миллиардов рублей больше, чем в текущем финансовом году. Из этой суммы 129 миллиардов рублей будет выд

Новый спортивный комплекс появится в городе

В ходе сегодняшнего рабочего совещания, проведённого губернатором Санкт-Петербурга Александром Бегловым с представителями городского правительства, было принято решение о выделении земельного участка, расположенного на улице Аккуратова, Фонду поддержки социальных инициатив «Газпрома». Этот участок предназначен для возведения современного крытого двухэтажного спортивного комплекса, включающего в себя футбольное поле. Губернатор Беглов особо подчеркнул, что это уже второе предоставление земельного

Утверждены 14 лауреатов Молодёжной премии Санкт‑Петербурга

Губернатор Санкт-Петербурга Александр Беглов утвердил распоряжение городского правительства о вручении Молодежной премии Санкт-Петербурга в 2025 году. Это ежегодная премия, учрежденная в 2002 году, которая присуждается за значительные достижения и успехи в различных сферах деятельности в Санкт-Петербурге. Среди таких сфер – наука, культура, искусство, образование, а также другие виды деятельности, имеющие выдающийся характер.

В Осиновой Роще открылось новое общественное пространство

В Осиновой Роще, расположенной неподалёку от Юкковского шоссе, появилось новое общественное пространство, предназначенное для отдыха жителей близлежащего современного жилого комплекса. Это пространство включает в себя современную детскую игровую площадку, оснащенную новейшим оборудованием, и две зоны, специально оборудованные для комфортного отдыха взрослых. Создание данной площадки стало возможным благодаря реализации городской программы «Петербургские дворы», стартовавшей в 2022 году. За проше

Большой семейный фестиваль пройдет Парке Героев-Пожарных

В Санкт-Петербурге, в Парке Героев-Пожарных, 13 и 14 сентября состоится масштабное мероприятие – Большой семейный фестиваль. Этот фестиваль, организуемый в ближайшие выходные, ориентирован на жителей и гостей Фрунзенского и Колпинского районов города. В течение двух дней, с 11:00 до 17:00, посетителей ждет насыщенная программа, включающая в себя более сорока бесплатных мастер-классов, интерактивных занятий и масштабных игр, которые будут организованы на двадцати восьми тематических площадках.

В канун Нового года фасад Дома Зингера украсила новая художественная подсветка

В преддверии Нового года фасад знаменитого Дома Зингера, расположенного на углу Невского проспекта и канала Грибоедова, был украшен новой художественной подсветкой. Теперь очертания и декоративные элементы этого известного здания выделяются благодаря 539 современным светодиодным светильникам. Количество установленных светильников увеличилось вдвое, однако потребляемая мощность осталась на прежнем уровне – около 10 кВт. Освещение подключено к линиям городской электросети Ленсвет. «Дом Зингера» яв

Вторая Санкт‑Петербургская гимназия отмечает 220 годовщину